Probabilmente chiunque di noi si sia cimentato nella creazione di un sito web finalizzata poi ad un buon posizionamento sui motori di ricerca si è trovato a dover lavorare sull’ottimizzazione onpage e quindi probabilmente a combattere con uno dei nemici più agguerriti in questo ambito: i contenuti duplicati! La loro nascita è spesso riconducibile ad errori concettuali o strutturali effettuati in fase di progettazione o all’utilizzo di un CMS poco ottimizzato ma a volte può essere dovuta anche a delle scelte obbligate che ci costringono ad optare per una struttura del sito particolare e che di fatto genera numerosi duplicati.

Ma andiamo alla genesi e scopriamo meglio di che cosa stiamo parlando.

Che cosa sono i contenuti duplicati in un sito web?

Di fatto possiamo definire duplicato un contenuto che pur presentando lo stesso testo o una grande porzione di esso è identificato da due url differenti; la duplicazione avviene solitamente per una serie di cause fra cui:

- Url dell’articolo contenente l’ID della sessione

- Appartenenza di un articolo a più categorie e utilizzo della categoria nell’url.

- Opzioni varie di ordinamento dell’articolo (sord by date, sort by category, etc…)

- Duplicazione dovute al dominio (sottodomini per il mobile, non www – www resolve).

- Introtext troppo lunghi nella visualizzazione degli articoli per categoria.

Come possiamo intuire, l’origine dei duplicati è molteplice e spesso una piccola dimenticanza in fase progettuale può essere devastante in termini di contenuti duplicati tanto che difficilmente riusciremo a prevenirli tutti a priori.

Perché i Duplicati sono così negativi per un sito web?

Cercherò di spiegarlo in parole molto semplici: immaginate di avere un calice di vino prelibatissimo di fronte a voi e per dividerlo con un’altra persona e non far torto a nessuno decidiate di “diluirlo” con dell’acqua. Probabilmente il risultato non sarà più quel vino prelibato che avreste bevuto tenendo il contenuto in un solo calice e non diluendolo.

Così accade per i contenuti “diluiti” tra più url che di fatto vedono ridotto il proprio ranking nei confronti di Google.

Prevenire o Curare?

Come spesso accade la verità sta nel mezzo e in realtà una strategia efficace sta nel prevenire il più possibile prima e curare poi ciò che è sfuggito dalle nostre pazienti mani. In fase di progettazione consideriamo quindi di utilizzare delle estensioni seo-friendly che spesso ci possono venire incontro in tal senso, nel caso i nostri articoli siano collocati all’interno di categorie e ci trovassimo di fronte alla necessità di mostrarli all’interno della categoria utilizziamo degli introtext brevi inserendo il read more successivamente per consentire all’utente di visualizzare l’articolo (o la scheda prodotto) più approfonditamente. Evitiamo, se proprio non necessari, i famosi pulsanti per convertire in pdf o mandare via mail l’articolo, spesso generano anch’essi una duplicazione dei contenuti.

Un ulteriore passo è quello di ottimizzare gli url con un sistema di url rewrite che prescinda da una serie di elementi di disturbo quali l’id della sessione o altri suffissi che spesso compaiono.

Una volta fatto ciò probabilmente avremo arginato una parte del nostro problema ma sicuramente non l’avremo risolto. Come fare?

Come individuare e combattere i contenuti duplicati.

La prima regola dei contenuti duplicati è che spesso, soprattutto per chi è alle prime armi, sfuggono al nostro controllo diffondendosi come un morbo nel nostro sito web a nostra insaputa. la prima cosa da fare è quindi stanarli utilizzando gli strumenti per webmaster di google.

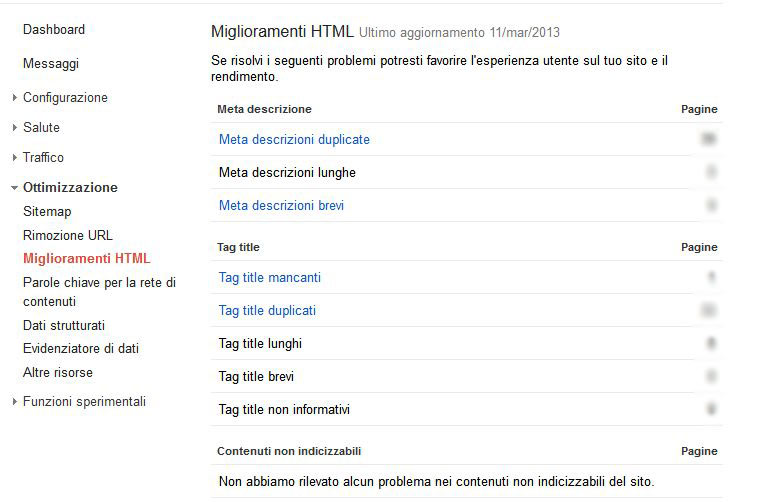

Da questo pannello che vedete a cui potete accedere da Ottimizzazione>Miglioramenti HTML potrete ottenere la lista dei contenuti duplicati e se lo vorremo salvarla in formato CSV o google document. Uno strumento che allo stesso tempo può esservi utile per monitorare l’indicizzazione dei contenuti è Screaming Frog, completamente gratuito e che potete trovare qui.

Molto bene, abbiamo identificato tutti i duplicati del nostro sito web a questo punto non ci rimane che eliminarli se possibile o arginarli con l’utilizzo di alcuni utili strumenti:

Utilizzo del Redirect 301

La cosa più semplice da fare per limitare i contenuti duplicati è effettuare un semplice redirect, in poche parole si fa in modo che gli url frutto di duplicazione puntino tutti verso il principale redirezionando. Il metodo è piuttosto semplice e lo si effettua editando il file htaccess.txt (o .hataccess in alcuni casi) del proprio sito web inserendo manualmente i redirect da effettuare.

La sintassi da utilizzare è la seguente:

redirect 301 /urlduplicato.html http://www.nomedominio.it/url-univoco-a-cui-puntare-html

Utilizzo del Disallow dal file robots.txt

Un metodo alternativo a quello del redirect può essere quello del disallow, in parole povere creare una regola editando il file robots.txt secondo la quale gli spider di google non prenderanno in considerazione il contenuto all’interno determinati url o cartelle del nostro sito web. Questo metodo può essere molto efficace soprattutto se impareremo ad utilizzare i caratteri jolly per escludere determinati contenuti derivati da url duplicati che sovente derivano dall’identificazione di sessione o altre funzionalità simili; in tal caso infatti spesso l’url contiene dei caratteri speciali come dei ? al suo interno, vi faccio un esempio:

http://www.nomedominio.it/articolo.html?tmpl=component&print=1

Come vediamo in questo caso il nostro url contiene un punto di domanda al proprio interno in questo caso generato dal famoso pulsante di stampa di un articolo. In questi casi avvalendoci delle numerose regole di sintassi da implementare nel file robots.txt possiamo generare un disallow ad hoc inserendo una stringa come questa:

User-agent: * Disallow: /*?

In questo caso saremo in grado di non rendere visibili i contenuti di quegli url agli spider tutti gli url del nostro sito web che contengono un punto interrogativo al loro interno.

NB: In questo caso va tuttavia fatta una precisazione, alcuni CMS implementano nativamente il redirect nel caso gli url contengano caratteri speciali al loro interno, in tal caso effettuare un disallow ci farebbe perdere quegli url. per questo è opportuno effettuare una verifica prima di procedere al disallow!

Un ringraziamento ad Andrea Pernici per la sua preziosa precisazione!

Per approfondire tutta la sintassi da implementare nel robots.txt vi rimando a questa esaustiva guida di google.

Implementazione del tag rel=canonical

L’implementazione del tag rel=canonical è forse la funzione più advanced tra quelle citate, ha il vantaggio che pur escludendo gli url duplicati alla vista di google crea una gerarchia al loro interno lasciandoci la possibilità di definire l’url principale che viene definito come “canonico”. la sua implementazione è particolarmente utile quando ci si trova di fronte a variabili url generate per ordinamenti vari degli articoli all’interno di categorie, quando lo stesso articolo viene pubblicato in vari formati oltra a quello normale (es. pdf). In questo caso non dovremo fare altro che designare un indirizzo canonico e tutti gli altri verranno visti da google come “indirizzi secondari” di minore rilievo che quindi non andranno ad intaccare il ranking dell’url canonico.

Il tag rel=canonical tuttavia non ha certezza matematica della propria applicazione, un po’ come accade con l’applicazione di un altro tag qual è il rel=author (per l’attribuzione dell’authorship dei vostri contenuti) google utilizza un proprio criterio discrezionale nella sua applicazione, per questo consiglio di porre la massima attenzione nella sua implementazione, in caso di errore infatti si rischia di avere più danni che benefici!

Ecco un esempio di url definito come canonical con il tag implementato:

<link rel="canonical" href="http://www.miodominio.it/articolo.html"/>

Se volete approfondire il tema sul rel=canonical vi consiglio di leggere questi due articoli, il primo di Andrea Pernici sul SEO Blog GT che potete trovare qui, il secondo del nostro Davide De Maestri sul suo sito web che potete trovare qui.

Utilizzo del Noindex

Se proprio non sappiamo che pesci pigliare possiamo decidere di escludere dall’indicizzazione di google determinati contenuti utilizzando la funzione noindex (da non confondere con il nofollow). Con l’utilizzo del noindex l’elemento designato verrà completamente ignorato dagli spider di google e non indicizzato, la differenza con il disallow è che il noindex agisce sul singolo elemento mentre il disallow crea le regole di accesso che vengono definite attreaverso la sintassi.

Abbiamo eliminato tutto?

Se abbiamo lavorato correttamente utilizzando le varie funzioni sopra elencate porgendo la massima attenzione (soprattutto per il rel=canonical) dovremmo aver limitato al massimo i nostri duplicati, certo per arrivare a buoni risultati serve davvero tanta precisione e un buon metodo di lavoro, di certo avrete creato una buona base per l’ottimizzazione del nostro sito e per facilitarne un buon posizionamento in futuro, è importante quindi non sottovalutare questi passaggi!

Naturalmente il tutto richiederà numerose gocce del vostro sudore per poter essere completato ma come si suol dire…..

No Pain No Gain!